Проблемы, возникающие при обучении слоя Кохонена

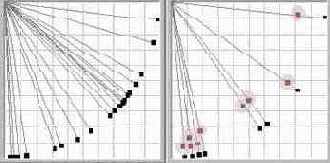

Для исследования динамики обучения и свойств слоя Кохонена был создан инструмент «Модель нейросети», в котором моделируется слой Кохонена в двумерном сигнальном пространстве (Рис 16).

Моделирование слоя Кохонена

1. Начальные значения весов 2. Веса после обучения

Рис.16

В инструменте моделируется нейросеть с двумя входами, так что она способна классифицировать входные вектора в двумерном сигнальном пространстве. Хотя функционирование такой нейросети и отличается от функционирования нейросети в сигнальном пространстве с гораздо большей размерностью, основные свойства и ключевые моменты данного нейросетевого алгоритма можно исследовать и на такой простой модели. Главное преимущество – это хорошая визуализация динамики обучения нейросети с двумя входами.

В ходе экспериментов с этой моделью были выявлены следующие проблемы, возникающие при обучении нейросети:

1. выбор начальных значений весов.

Так как в конце обучения вектора весов будут располагаться на единичной окружности, то в начале их также желательно отнормировать на 1.00. В моей модели вектора весов выбираются случайным образом на окружности единичного радиуса (рис. 16.1).

2. использование всех нейронов.

Если весовой вектор окажется далеко от области входных сигналов, он никогда не даст наилучшего соответствия, всегда будет иметь нулевой выход, следовательно, не будет корректироваться и окажется бесполезным. Оставшихся же нейронов может не хватить для разделения входного пространства сигналов на классы. Для решения этой проблемы предлагается много алгоритмов ([1],[8]). в моей работе применяется правило «желания работать»: если какой либо нейрон долго не находится в активном состоянии, он повышает веса связей до тех пор, пока не станет активным и не начнет подвергаться обучению. Этот метод позволяет также решить проблему тонкой классификации: если образуется группа входных сигналов, расположенных близко друг к другу, с этой группой ассоциируется и большое число нейронов Кохонена, которые разбивают её на классы (рис. 16.2).

Правило «желания работать» записывается в следующей форме:

wн=wc + a1

, (9)

где wн - новое значение веса,

wс – старое значение,

a1 - скорость модификации,

Выбор коэффициента a1 определяется следующими соображениями: постоянный рост весов нейронов по правилу (9) компенсируется правилом (7) (активные нейроны стремятся снова вернуться на гиперсферу единичного радиуса), причем за одну итерацию нейросети увеличат свой вес практически все нейроны, а уменьшит только один активный нейрон или нейронный ансамбль. В связи с этим коэффициент a1 в (9) необходимо выбирать значительно меньше коэффициента a в (7), учитывая при этом число нейронов в слое.

3. неоднородное распределение входных векторов в пространстве сигналов и дефицит нейронов.

Очень часто основная часть входных векторов не распределена равномерно по всей поверхности гиперсферы, а сосредоточена в некоторых небольших областях. При этом лишь небольшое количество весовых векторов будет способно выделить входные вектора, и в этих областях возникнет дефицит нейронов, тогда как в областях, где плотность сигнала намного ниже, число нейронов окажется избыточным.

Для решения этой проблемы можно использовать правило «нахождения центра масс», т.е. небольшое стремление ВСЕХ весовых векторов на начальном этапе обучения к входным векторам. В результате в местах с большой плотностью входного сигнала окажется и много весовых векторов. Это правило записывается так:

wн

= wс + a2(x

– wс). (10)

где wн - новое значение веса,

wс – старое значение,

a2 - скорость модификации,

x – входной вектор

Это правило хорошо работает, если нейроны сгруппированы в одном месте. Если же существует несколько групп нейронов, то это правило не дает нужного результата.

Ещё одно решение – использовать «отжиг» весовых векторов. В нашем случае он может быть реализован как добавление небольшого шума при модификации весов, что позволит им перемещаться по поверхности гиперсферы.

При обучении уровень шума постепенно понижается, и весовые вектора собираются в местах наибольшей плотности сигнала.

Недостаток этого правила – очень медленное обучение. Если в двумерном пространстве нейроны «находили» входные вектора более-менее успешно, то в многомерном пространстве вероятность этого события существенно снижается.

Самым эффективным решением оказалось более точное моделирование механизма латерального торможения. Как и раньше, находится нейрон с максимальной активностью. Затем искусственно при помощи латеральных связей устанавливается активность окружающих его нейронов по правилу (11):

где aj – активность нейрона

i - выигравший нейрон

j – индекс нейрона

При этом предполагается, что все нейроны имеют определенную позицию по отношению к другим нейронам. Это топологическое отношение одномерно и линейно, позиция каждого нейрона определяется его индексом. Правило (11) говорит о том, что возбуждается не один нейрон, а группа топологически близких нейронов. В результате обучения образуется упорядоченная одномерная карта признаков. Упорядоченность означает, что ближайшие два нейрона в ней соответствуют двум ближайшим векторам в пространстве сигнала, но не наоборот (так как невозможно непрерывно отобразить многомерное пространство на одномерное, [6]). Сначала радиус действия латеральных связей достаточно большой, и в обучении участвуют практически все нейроны. При этом они находят «центр масс» всей обучающей выборки. В процессе обучения коэффициент